텍스트와 멜로디로 음악을 만드는 새로운 AI 모델 - 메타의 MusicGen

- 메타(구 페이스북)에서도 AI로 음악 만들기에 나섰다.

- 텍스트만 입력하여 내가 원하는 음악을 만들고, 이미지를 음악으로 바꿔준다.

메타의 MusicGen

MusicGen은 메타 AI (구 Facebook AI Research)에서 개발한 오픈 소스 딥 러닝 언어 모델이다. 2023년 6월에 처음 공개 된 MusicGen은 텍스트 프롬프트 또는 기존 곡의 일부를 기반으로 새로운 음악을 생성할 수 있다.

1. 작동원리

- AI 번역의 예측 모델이 적용되었다.

- '트랜스포머(Transformer)'라는 딥러닝 모델 기반으로 작동한다. 트랜스포머는 자연어 처리 분야에서 널리 사용되는 모델로, 문장의 의미를 이해하고 다음 단어를 예측하는 데 능숙하다.

- 챗 gpt가 글을 작성할 때 다음 글자를 생각해서 넣는 것처럼 뮤직젠은 트랜스포머 모델을 음악 데이터에 적용하여 음악의 다음 구간을 예측하고 새로운 음악을 생성한다.

2. 뮤직젠의 주요 기술

- 딥 러닝 - 음악 데이터 세트에서 학습된 패턴을 활용하여 음악 생성

- 자연어 처리 - 텍스트 프롬프트를 이해하고 음악 생성에 활용

- 음악 정보 추출 - 기존 곡에서 음악 스타일, 분위기, 장르 등을 추출하고 음악 생성에 활용

3. 주요 특징

- 텍스트 기반 음악 생성

- 사용자가 입력한 텍스트를 기반으로 새로운 음악 생성

- 음악 스타일, 분위기, 가사 등을 텍스트로 지정하여 원하는 음악을 만들 수 있다.

- 멜로디 기반 음악 생성

- 기존 멜로디를 기반으로 새로운 음악 생성

- 사용자가 직접 멜로디를 입력하거나 흥얼거려 음악을 만들 수 있다.

- 다양한 음악 스타일

- 팝, 록, 클래식, 재즈 등 다양한 음악 스타일 지원 →사용자의 취향에 맞는 음악 스타일을 선택하여 원하는 음악을 만들 수 있다.

- 사용 편의성

- 웹 기반 인터페이스로 누구나 쉽게 사용할 수 있다.

- 별도의 프로그램 설치나 코딩 지식이 필요하지 않다.

- 간단한 몇 번의 클릭만으로 원하는 음악을 만들 수 있다.

- 오픈 소스

- 코드 및 모델 GitHub에서 오픈 소스로 공개 되어 누구나 자유롭게 사용하고 개선할 수 있다.

4. 주의해야 할 점

- 뮤직젠은 아직 개발 초기 단계에 있으며, 완벽한 모델이 아니다.

- 생성된 음악의 품질은 사용자의 입력과 컴퓨팅 환경에 따라 달라질 수 있다.

- 오픈소스 모델을 사용할 때에는 저작권 문제에 유의해야 한다.

5. 사용 방법

- 메타의 MusicGen은 10~30초 정도의 음악을 만들 수 있다.

- 요소요소 다 지정해 줘야 제대로 만들어진다.

→ 비트는 얼마로, 스타일은, 악기는, 구체적인 분위기 등등

- 영어로 입력해야 한다.

→ 챗 gpt나 바드, 구글 번역에서 내가 원하는 표현을 영어로 번역하여 사용하면 된다.

- 10~30초 정도 분량으로 음악을 생성시킨다.

→ 시간을 내가 지정할 수는 없다.

▶ 구글 검색 창에 MusicGen 입력 - 검색 - 첫 검색 결과인 Hugging Face 사이트 클릭

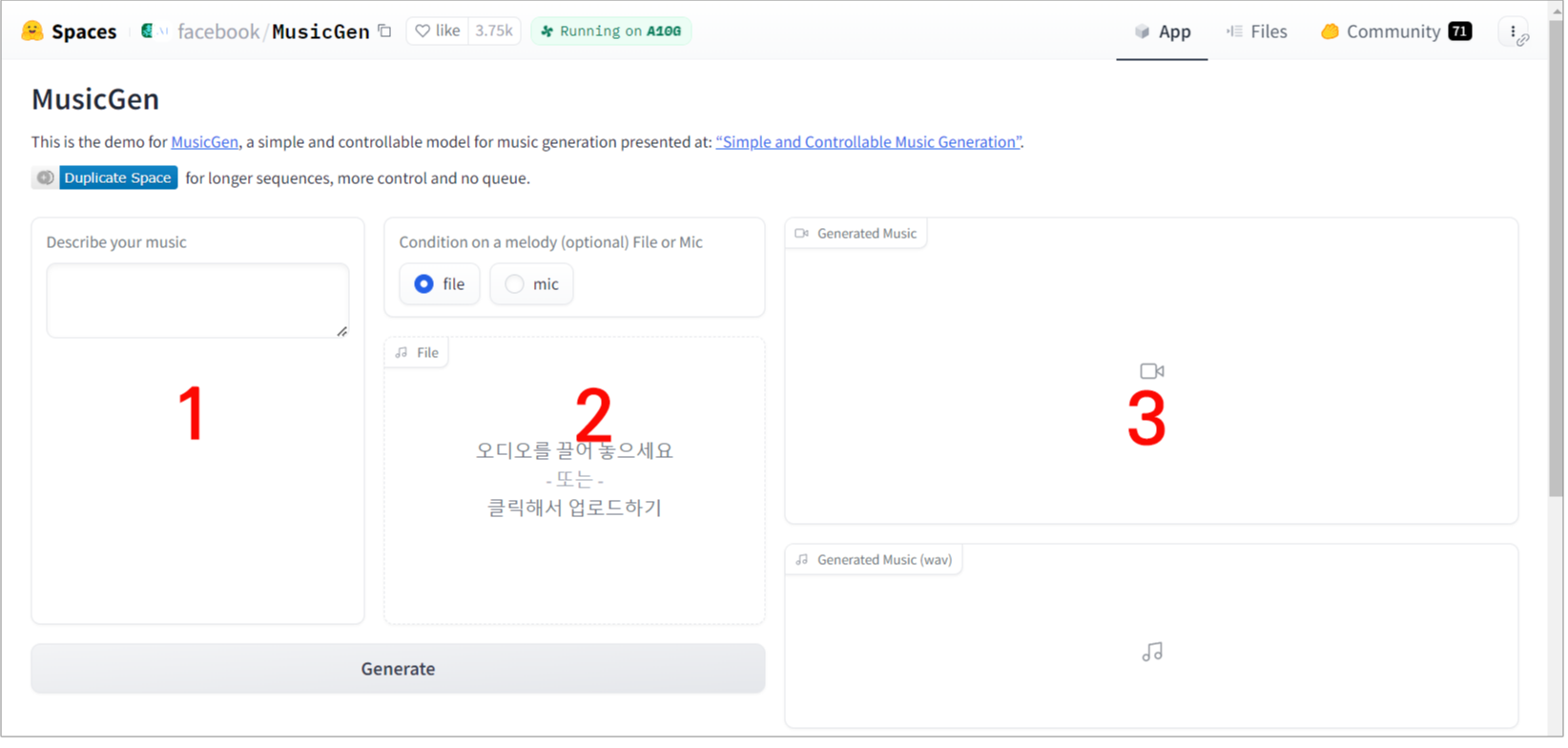

화면 구성

1 Describe your music - 원하는 음악을 텍스트로 입력한다.

2 Condition on a melody (optional) File or Mic - 원하는 멜로디가 있다면 해당 멜로디의 오디오 파일 추가 할 수 있다.

3 Generated Music - 생성된 음악 창

▶ 왼쪽 네모 칸에 내가 원하는 음악을 영어로 설명하여 입력 - 하단의 Generate 클릭

→ 오른쪽 상단에 음악이 생성된다.

- 챗 gpt나 Gemini, 구글 번역 등을 이용하여 내가 원하는 음악을 영어로 번역하여 입력한다.

예) A cheerful country song with acoustic guitars. (어쿠스틱 기타와 함께하는 경쾌한 컨트리송) 음악을 생성해 보자.

▶ 원하는 음악 영어로 입력 - 하단의 Generate 클릭 - 오른쪽 상단에 생성된 음악에서

→ 하단의 '▶'를 클릭하여 재생

→ 생성된 음악 오른쪽 상단의 다운로드 클릭하여 저장할 수 있다.

→ 마음에 들지 않으면 Generate 클릭하여 다시 생성할 수 있다.

생성된 음악